Este año académico he estado leyendo mucho sobre compactificaciones, tanto a nivel de matemática pura (holonomía a fondo, espacios de moduli bastante a fondo y otras cosas bastante recientes de geometría analítica de las que creo que no hay aún nada o casi nada aplicado a la teoría de cuerdas) cómo a nivel de fenomenología, con la idea de trabajar en dos temas bastante concretos, uno puramente matemático y otro muy fenomenológico.

En el proceso, aparte de aprender sobre compactificaciones, he podido entender mucho mejor diversos aspectos de la teoría de cuerdas en general, y, en particular, todo lo de los móduli, que es un asunto bastante clave. También me ha influenciado un aspecto del LHC, el de las fluctuaciones estadísticas. En principio se supone que son sólo éso, pero entendiendo un poco la física de compactificaciones uno podría plantearse que a lo mejor las fluctuaciones tienen que ver con sucesos reales de nueva física, pero que desaparecen con el tiempo porque la física mas allá del modelo standard pueda no ser constante. Por supuesto a muy altas energías la física no variaría, y estaría dictada por la teoría de cuerdas. Sin embargo en regiones intermedias, entre el modelo standard y la energía de Planck, la teoría de cuerdas se manifiesta por, entre otras cosas, las compactificaciones y, tal vez, estas podrían no ser constantes en el espacio o en el tiempo, y, de esa manera, la física efectiva a esas energías intermedias podría no ser constante.

En esta entrada voy a exponer aspectos serios, al menos eso espero, sobre el asunto, y, al final, otros un poco mas exóticos, con consideraciones de un carácter mas anecdótico, aunque tal vez no del todo irrelevantes.

La idea parte de lo más elemental, la idea de Kaluza-Klein es relativamente sencilla de entender una vez se sabe relatividad general. La idea básica es añadir una dimensión espacial extra a las 3+1 del espacio-tiempo y hacer que esta sea un círculo. Sí en vez de 3+1 tomáramos 2+1 tendríamos un plano y a cada punto del plano le añadiríamos un pequeño círculo cuyo radio sería del orden de la longitud de Planck, o algo muy pequeño en cualquier caso. Matemáticamente podemos expresar éso cómo que tenemos un producto cartesiano de espacios topológicos  (dónde

(dónde  es el espacio de Minkowsky en 3+1 dimensiones y

es el espacio de Minkowsky en 3+1 dimensiones y  es el círculo). Sí congelamos el tiempo, o aceptamos que la compactificación no varía con el mismo (que es lo que se suele hacer) tendríamos que el espacio es

es el círculo). Sí congelamos el tiempo, o aceptamos que la compactificación no varía con el mismo (que es lo que se suele hacer) tendríamos que el espacio es

Los círculos de los diversos puntos se agrupan y dan lugar a un cilindro y la métrica de ese círculo, vista desde el espacio de 3 (2 sí estamos en el plano) dimensiones es la del electromagnetismo de Kaluza. Sí consideramos una partícula cuántica que pueda tener momento en la dirección de ese círculo ése estará cuantizado. Desde 4 dimensiones el momento en esa quinta dimensión se verá cómo una masa y una partícula, inicialmente sin masa,va a tener «copias» de diversas masas, múltiplos enteros unas de otras. Siendo relatividad general estamos trabajando con geometría diferencial intrínseca, y, por consiguiente, nos despreocupamos de cómo ese círculo, y el correspondiente cilindro, se pueden «encajar» en las dimensiones extra. También se asume normalmente que el radio del círculo es uniforme. Sí no lo fuera siempre podríamos decir que tenemos lo que se denomina una fibración con base el espacio de Minkowsky y fibra  .

.

Las fibraciones son un tema matemático que requiere bastante esfuerzo introducir en detalle, y que requiere una buena base previa de geometría y topología a nivel de una licenciatura de matemáticas. De hecho es un tema para un quinto curso (algo que ya no existe en el plan de bolonia) o directamente para cursos de postgrado. Aún así la idea esencial no es terriblemente difícil de entender intuitivamente. Se trata de que a cada punto de un espacio denominado base B se le «pega» una copia de otro espacio F, denominado fibra. Juntando las fibras de todos los puntos se obtiene el espacio total, E, y hay una proyección  que va del espacio E al espacio B que lleva cada fibra al punto del espacio B al que pertenece.

que va del espacio E al espacio B que lleva cada fibra al punto del espacio B al que pertenece.

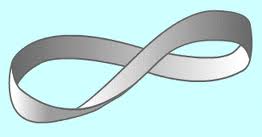

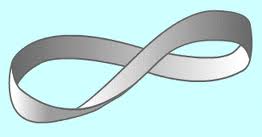

En cierto modo las fibraciones son una generalización del producto cartesiano y, de hecho, cuando la fibración es trivial el espacio total E es el producto cartesiano de la base por la fibra E=BxF, pero,en general, el asunto es mas complejo (aunque, localmente, el espacio sí que va a ser siempre un producto cartesiano dela base por la fibra, pero globalmente, en general, no) . Una forma muy sencilla de verlo es cuando el espacio base es un círculo y la fibra es un segmento. En ese caso el producto cartesiano es un anillo (un cilindro sin las tapas, vaya). Sin embargo en general no tiene porque ser así. Sí en cada punto del círculo la inclinación del segmento va cambiando el espacio total no va a ser ya un anillo. Un caso particular es cuando el último segmento está en la dirección opuesta al primero y se identifican ambos segmentos. En ese caso obtenemos la banda de Moëbius.

En las definiciones anteriores he sido muy impreciso. Normalmente se va a imponer que la fibra tenga alguna estructura extra. Por ejemplo sí F es un espacio vectorial vamos a tener un fibrado vectorial. Un ejemplo de éso sería el espacio vectorial tangente a una variedad. Sí la fibra es un grupo (normalmente un grupo de Lie) vamos a tener un fibrado principal. Hay un montón de estructuras extra que se pueden ir añadiendo al concepto de espacio fibrado, y, realmente, es una rama muy fecunda de la matemática, con múltiples aplicaciones a la física. Se puede, por ejemplo, formular una teoría gauge de grupo G cómo un fibrado principal con el mismo grupo. Los campos fermiónicos cargados bajo ese grupo formarían una fibrado vectorial asociado. ES un tema interesante y bonito, pero no es lo que me interesa tratar aquí. Hay libros de geometría y topología para físicos que hacen buenas y extensas introducciones al tema, cómo, por ejemplo, el de Nash y Shen o el Nakahara. También se pueden leer unas definiciones un poco mas formales en la wikipedia

Volviendo al tema de las compactificaciones, sí consideramos que el espacio base  , que no hay dependencia en el tiempo, y por tanto sólo nos importa la parte espacial del espacio de Minkowsky en tres dimensiones, tenemos que la base es

, que no hay dependencia en el tiempo, y por tanto sólo nos importa la parte espacial del espacio de Minkowsky en tres dimensiones, tenemos que la base es  . Si tenemos que el radio pueda variar de un punto a otro la fibra es

. Si tenemos que el radio pueda variar de un punto a otro la fibra es  . Hay que analizar ésto último con un poco mas de detalle si queremos ser rigurosos. Normalmente sólo se habla de espacios fibrados, al menos en geometria y topología diferencial, cuando son o bien fibrados vectoriales o bien principales. Posiblemente en física se suele ser mas descuidado y se admite como fibra «cualquier cosa» y cómo «fibrado» cualquier cosa que localmente es un producto, aunque globalmente no lo sea. Afortunadamente en este caso podemos ser «ortodoxos». Podemos ver que en el plano complejo (que topológicamente es equivalente al plano real) el círculo son los puntos de la forma

. Hay que analizar ésto último con un poco mas de detalle si queremos ser rigurosos. Normalmente sólo se habla de espacios fibrados, al menos en geometria y topología diferencial, cuando son o bien fibrados vectoriales o bien principales. Posiblemente en física se suele ser mas descuidado y se admite como fibra «cualquier cosa» y cómo «fibrado» cualquier cosa que localmente es un producto, aunque globalmente no lo sea. Afortunadamente en este caso podemos ser «ortodoxos». Podemos ver que en el plano complejo (que topológicamente es equivalente al plano real) el círculo son los puntos de la forma  siendo el producto de grupo la multiplicación de números complejos. Si R=1 tenemos el círculo unidad, pero, en general, para cualquier R (real) tenemos un círculo de ese radio. Por tanto podemos decir que nuestro fibrado es un fibrado principal. Cómo en la condición de fibrado nos preocupamos de que el espacio producto sea localmente un producto topológico, y en topología podemos cambiar libremente los tamaños, no pasa nada porque el radio varíe de un punto a otro.

siendo el producto de grupo la multiplicación de números complejos. Si R=1 tenemos el círculo unidad, pero, en general, para cualquier R (real) tenemos un círculo de ese radio. Por tanto podemos decir que nuestro fibrado es un fibrado principal. Cómo en la condición de fibrado nos preocupamos de que el espacio producto sea localmente un producto topológico, y en topología podemos cambiar libremente los tamaños, no pasa nada porque el radio varíe de un punto a otro.

Por supuesto toda esa consideración anterior sobre fibrados nos la podríamos haber ahorrado y dejar variar el radio del círculo sin mayores consideraciones. Realmente que algo sea un fibrado, en particular un fibrado principal, es útil porque se pueden crear espacios recubridores que caracterizan mediante clases topolóigicas (clases caracteristicas) los diversos espacios totales que se pueden formar con una base y una fibra dada. Dependiendo del tipo de grupo las clases serán de Stieffel-Wittney , de Chern o de pontryagin, y también éso puede ser útil en física de teorías gauge para tratar temas como los instantones y los solitones. Sí lo he incluido es porqué normalmente en la literatura física se trata el tema de forma muy descuidada y me parecía interesante dar algunas explicaciones al respecto.

Realmente el asunto del radio del círculo de la compactificación es un asunto delicado, incluso sí no nos planteamos que varíe en el espacio. En la teoría de Kaluza-Klein es un valor que viene dado y no está determinado por nada dentro de la propia teoría. Sin embargo las cantidades observables en el espacio ordinarios sí van a depender del radio de ése círculo. Por ejemplo, la constante gravitatoria en cuatro dimensiones estará relacionada con la de cinco por la relación  y los valores de las copias K-K de una partícula van a tener masas

y los valores de las copias K-K de una partícula van a tener masas  . También la constante electromagnética va a depender del radio de ese círculo, y, en general, prácticamente todo ¡Y nada fija el valor de ése círculo!.

. También la constante electromagnética va a depender del radio de ese círculo, y, en general, prácticamente todo ¡Y nada fija el valor de ése círculo!.

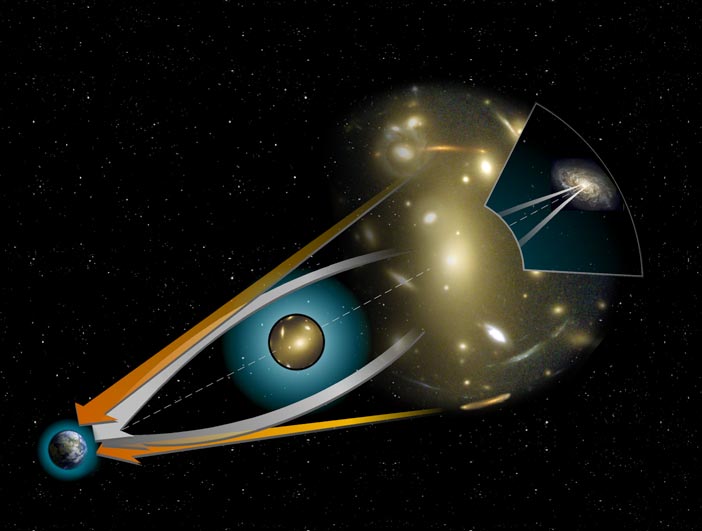

Durante bastante tiempo en la teoría de cuerdas nadie se preocupó demasiado del asunto. La primera persona, que yo sepa, que primero insistió en que había que ocuparse de ver cómo debería haber algo que fijara el tamaño de ése círculo fue un famoso crítico de la teoría de cuerdas, Lee Smollin. En terminología de cuerdas el radio de ése círculo es un «móduli» y fijar el tamaño del círculo es «la estabilización del móduli». El concepto de móduli lo introdujo Riemman, y, más o menos, viene a ser un parámetro, pero, desde luego, la historia es algo mas compleja que éso y la teoría de los moduli es muy rica, a la par que complicada, y no voy a entrar ahora a discutirla matemáticamente. En cualquier caso, usando «compactificaciones de flujo» se ha, más o menos, resuelto parcialmente el problema de la estabilización de los moduli en teoría de cuerdas, aunque al precio de introducir el landscape, pero bueno, ésa es otra historia. Un aspecto interesante es que en las compactificaciones tipo flux,el flujo que les da nombre es un flujo de unos campos antisimétricos (representables mediante formas diferenciales) que están en el espectro de la teoría de cuerdas que son unos análogos mas generales del campo electromagnéticos. Las fuentes de ésos campos van a ser D-branas. Sí uno considera el campo gravitatorio de una D-Brana va a obtener que el espacio-tiempo alrededor de la D-brana va a ser un «braneworld» a lo Randall-Sundrum, y va a estar «warped» (algo así cómo retorcido). Esos espacios warped ya no van a tener estructura de producto cartesiano, incluso aunque el valor de los moduli no varíe y, por tanto, tampoco va a ser una fibración cómo la que expliqué antes.

En la resolución habitual del problema de los móduli el valor del móduli, en éste caso de el radio del círculo, es la misma en todo el espacio-tiempo, aunque no es imposible buscar casos en que ésto no sea así. En general, en teoría de cuerdas, la historia es mas compleja y las compactificaciones tienen muchos moduli. Podemos entender intuitivamente que el móduli es un parámetro que nos indica cómo podemos modificar un espacio para que cambien algunos aspectos del mismo, pero sin afectar la estructura fundamental del mismo. En el caso del círculo el único moduli es el radio. En el caso del toro, que hay dos círculos, tenemos un moduli que seria el cociente del radio de los dos círculos (y que daría toros mas gordos y toros mas fínos) y otro algo más sutil de entender que no explicaré. En general, para una compactificacion típica de Calabi-Yau, de tres dimensiones complejas, el espacio de moduli es muy amplio, y, además, se descompone en dos partes: modulis de forma, y módulis de tamaño. La física en las 4 dimensiones va a depender de muchos aspectos de ésos Calabi-Yaus. Alguna va a depender propiedades independientes de los moduli, cómo por ejemplo el número de familias de partículas (que va a ser igual a la constante de Euler de el Calabi-Yau para la cuerda heterótica, y a los números de intersecciones de los ciclos de Calabi-Yaus en que se enrollan las D-branas en las cuerdas tipo II B, por sí tenéis curiosidad y sabéis más o menos de que hablo xD). Otras propiedades, por contra, sí van a depender de los móduli. Aparte de los moduli hay otro campo, el dilatón, que va determinar la fisica de las 4 dimensiones. Normalmente el valor del dilatón no varia en el espacio, pero hay compactifícaciones en las que sí (y en teoría F se combina con un axión formando el axio-dilatón, que es un fibrado elíptico y, por tanto, de manera natural varia).

Éso lleva a que uno debería plantearse que pudiera darse el caso de que la física en cuatro dimensiones pudiera depender del punto del espacio, y, si acaso, que variase en el tiempo. Hay limitaciones experimentales muy serias sobre las posibles variaciones de las propiedades (por ejemplo masa) partículas del modelo standard y sobre los valores de las variables de acoplo gauge y no parece que varíen en absoluto. Pero podría ser que la física mas allá del modelo standar sí lo hiciera. Cómo no conocemos física mas allá del modelo standard no tenemos noticias al respecto. Pero sería muy interesante especular con las implicaciones de que fuera variable. En ese caso las masas de las partículas no osbervadas, y las secciones eficaces de producciones de las mismas, podrían variar en el tiempo o el espacio. En realidad, dado que la tierra se mueve, sí solo varían en el espacio, desde el punto de vista de la tierra sería cómo si variasen en el espacio. Éso sí, las variaciones no serían totalmente al azar sino que estarían determinadas por la teoría de cuerdas y unas variaciones estarían correlacionadas con otras. Por otro lado sería natural que esas variaciones tuvieran algún tipo de estructura periódica. En ese caso podría ocurrir que una partícula, en un instante dado, tuviera una alta sección eficaz de producción, y apareciera cómo una desviación estadística en el LHC. Pero, según la tierra se mueve (o el tiempo avanza) su sección eficaz de producción bajaría y parecería haber sido una mera fluctuación estadística. El caso es que, sí es la física 4d, que depende del espacio-tiempo al ser la compactificación no constante en el mismo, si supieramos, más o menos, que compacticiación tenemos, podríamos saber que sí han aparecido unas fluctuaciones A y B entonces deberían aparecer otras, C y D, y que, luego, en otro momento volverán A y B.

Realmente el tema de las compactificaciones variables ha sido tratado en la literatura, pero de manera muy dispersa. En cosmomlogía Kolb, en 1986, consideró compactificacoines toroildales con radios variables, pero no se obtuvo nada útil (se puede ver una introduccion al tema en el capítulo de cosmologías en dimensiones extra del libro de Collins-Martin-Squires «particle physics and cosmology). Realmente es difícil dar en la literatura con algo al respecto. Unos autores, por ejemplo, han considerado algo parecido, en modelos con D-Branas, en las que la posición de unas D-branas varían de un punto a otro, y lo llaman «soft branas». Un articulo reciente que trata el tema es Inhomogeneous compact extra dimensions. En todo caso ninguno de los artículos que he encontrado plantea el tema de la forma que lo he expuesto aquí, es decir, analizando las consecuencias para el LHC en forma de «partículas de Cheshire», que, cómo el gato de Cheshire, aparecen y desaparecen cómo si fueran fluctuaciones estadísticas. Tengo muy perfilado un artículo en el que basándome en un modelo de intersecciones de D-branas en ciclos de Calabi-Yau, considerado cómo modelo genérico para predicciones de cara al LHC de éste tipo de escenarios de teoría de cuerdas, permito que el dilatón varíe en el espacio, y así obtener unas predicciones, también, genéricas de cómo podría variar el asunto. Realmente sería mas interesante ver sí alguno de los modelos propuestos para el famoso LHC bumb a 750 GeV, que apareció a 4.X sigmas, y luego se desvaneció, puede encuadrarse en una compactificación variable y ver sí esa fluctuación se puede haber ido a algún otro sítio (o sítios) en los que también darían alguna pequeña fluctuación observable y, en ése caso, se tendría una predicción basada en teoría de cuerdas para el LHC. Obviamente el asunto es muy complicado, y requiere manejar muchos aspectos de fenomenología, cómo encontrar el superpotencial, encontrar cómo se rompe la supersimetría por ese superpotencial, la masa de las partículas resultantes, y cómo esa masa depende de los móduli, y lo mismo para las secciones eficaces de las partículas con esas masas. Mucho me temo que, aunque conozco la materia, no tengo la soltura para obtener los cálculos detallados con demasiada presteza. Afortunadamente tengo ideas para otras cosas que requieren menos tecnicismos tan extensos :).

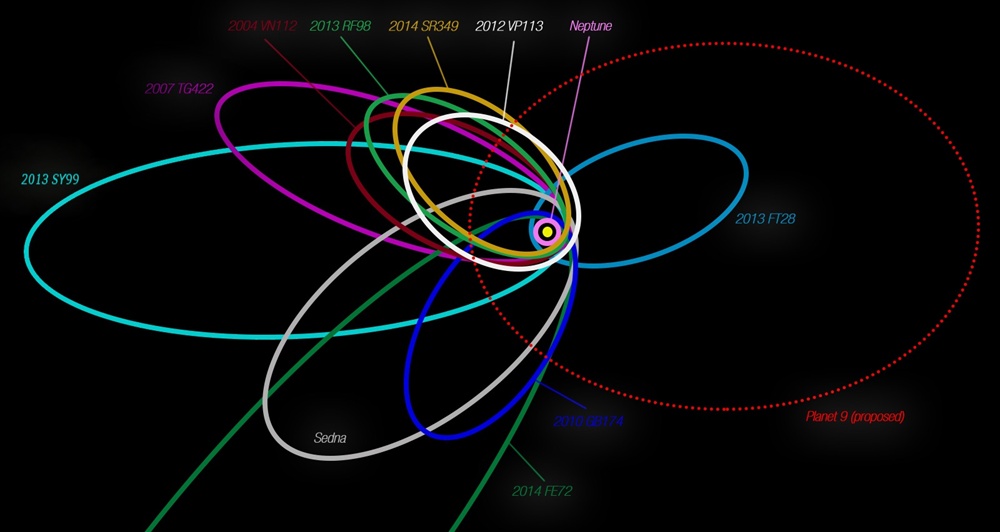

Tal vez es muy optimista pensar que las variaciones sean sustanciales en las distancias que pueda recorrer la tierra en el periodo de unas horas o incluso años. Tal vez haya fluctuaciones, pero sólo a muy gran escala. En ese caso habría también consecuencias posibles. En el escenario WIMP para la materia oscura normalmente ésta va a ser el LSP (partícula supersimétrica mas ligera). Pero sí la masa de esa partícula varía de una zona a otra del espacio, y esas partículas, o las que terminaron decayendo en esa partícula, se formaron muy al inicio del universo, entonces la partícula LSP (o en general, las que formen la materia oscura) podrían tener masas diferentes en diferentes zonas del universo. Éso sí, por diversos procesos se habrán podido ir mezclando unas con otras y, en el universo actual, habrá, en una zona dada, partículas de materia oscura que provengan de diversas zonas del universo y que, según ese esquema, tendrán diferentes masas para el mismo tipo de partícula. Cómo los experimentos actuales buscan una partícula que siempre va a tener la misma masa entonces es muy probable que fallen en su búsqueda, que, de hecho, es lo que está pasando. Obviamente hay muchos motivos por los que puede fallar esa búsqueda que no sea éste, pero quizás sería interesante plantearse sí hay modificaciones de los experimentos que puedan tener en cuenta escenarios de este tipo.

Hasta ahora todo lo que he escrito es bastante serio y relativamente ortodoxo. Voy ahora con la parte menos seria, que se me ha ocurrido al analizar lo anterior. Una de las cuestiones sobre la estabilización de los móduli es que habría que plantearse cómo el valor que tome en un punto va ser igual al que tenga en otro punto. He dicho que los moduli los van a fijar los flujos, pero no he dado todos los detalles. Un aspecto muy molesto en la literatura física es que cuando se habla de móduli muchas veces se dice que estos son campos escalares. De hecho los moduli no sólo aparecen en teoría de cuerdas sino en vacíos de teorías de campo supersimétricas, o en los espacios de móduli de los instantones de las teorías gauge, y, dado que en teoría de cuerdas también hay instantones, pues hay un moduli space de instantones (que suelen hacer contribuciones no perturbativas a los potenciales). Hay todas esas acepciones y no siempre se tiene muy claro de que habla el autor. En todo caso, así, en líneas generales, el esquema es entendible. El móduli, como digo, es un parámetro que indica las deformaciones de una estructura geométrica (o una familia de estructuras geométricas). Un toro es una estructura geométrica, pero un toro concreto tiene unos radios y ángulos entre los círculos determinados. Bien, las deformaciones que llevan un toro a otro están dados por los moduli. Un toro, por cierto, es también una estructura de Riemman, es decir, una variedad compleja de dimensión, compleja, uno. Al espacio de moduli del toro también puede dársele estructura de espacio complejo, aunque, en general, los espacios de móduli van a tener algún tipo de singularidad. Bien, éso es la matemática del asunto. En física, en general, lo que va a ocurrir es que vamos a tener una compactificación, en la que van a vivir una serie de campos. Se puede calcular (hay fórmulas relativamente tratables para ello) la dimensión del móduli space en términos de clases características y, en última instancia, de los números de Betti del espacio de la compactificación . Resulta que, en general, para cada móduli geométrico la teoría de cuerdas nos va a dar un campo escalar. Pues bien, los flujos lo que van a hacer va a ser generar un potencial para ése escalar y, se supone, el campos va a ir al mínimo de ése potencial y, de ese modo, queda fijado el moduli correspondiente.

Bien, entonces una vez que entendemos que el móduli va estar asociado al al valor del mínimo del potencial de un campo escalar ya podemos empezar a plantear mejor la cuestión de cómo podría de ser ése mínimo distinto de un punto a otro. El caso de un campo escalar que toma un valor de mínimo existe en física ¡es el bosón de Higgs! Se supone que el bosón de Higgs estaba en un máximo inestable y, en un momento dado, en algún punto del espacio, cayó a un valor concreto de mínimo. Había un continuo valores posibles para el mínimo. Cómo el Higgs se puede mover en las 3 dimensiones espaciales se supone que una vez tomó el mínimo en un punto transmitió el valor al resto de puntos de las 3 dimensiones (una esfera de nuevo vacío expandiéndose a la velocidad de la luz).

Ahora bien, sí un campo escalar de moduli tuviera, por lo que fuese, varios posibles para el mínimo (hay potenciales con mas de un mínimo, vaya) y en un punto del espacio toma valor en uno de esos mínimos ¿puede transmitir ese valor a los puntos colindantes, y, en última instancia, a todo el espacio? Dado que el campo vive sólo en las dimensiones extra no puede (o no es obvio que pueda) transmitir ese valor a través del espacio 3d ordinario.

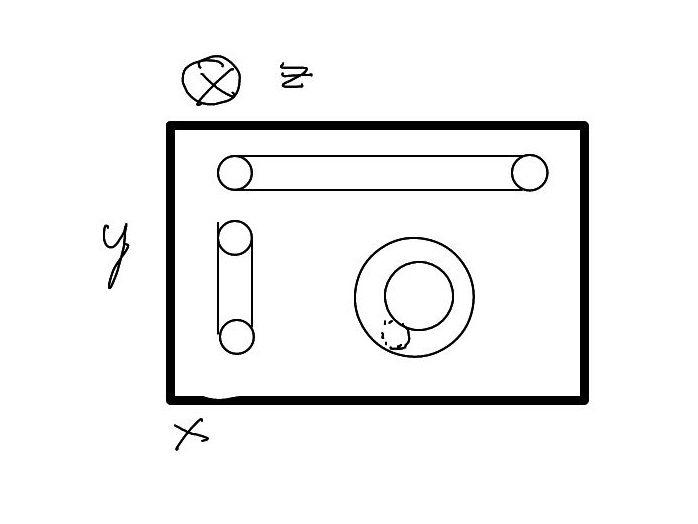

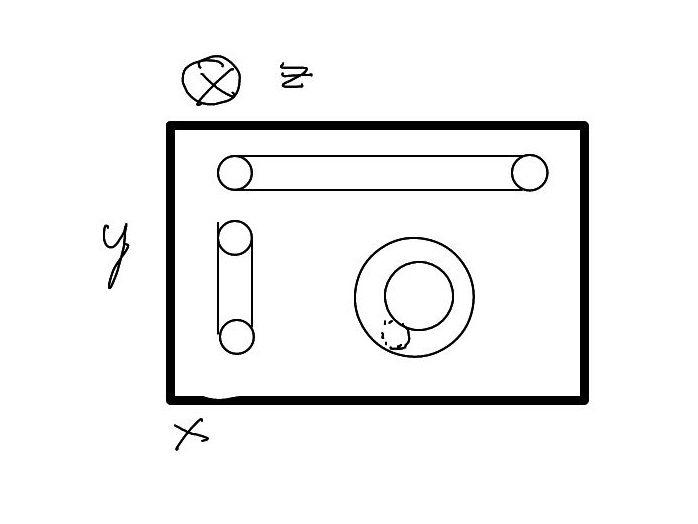

Pues bien, ahí es dónde entra el tema «poco serio», puras especulaciones mías un tanto descabelladas posiblemente, que voy exponer ahora. En las imágenes mentales de Kaluza-Klein se pinta, cómo ya dije, que la dimensión extra es una «manguera muy estrecha» sobre un plano. Es decir, se supone que los círculos de cada  toman la misma orientación en todos los puntos del espacio y forman un cilindro. Ahora bien ¿En que dirección? Es decir, podemos coger una línea paralela, por ejemplo,al eje x, y adosar un cilindro a cada una de esas líneas. Pero también podrían estar adosadas al eje y. O, otra posibilidad, es que la orientación de los círculos fuera variando y se cerrasen sobre un círculo dibujado en el plano.

toman la misma orientación en todos los puntos del espacio y forman un cilindro. Ahora bien ¿En que dirección? Es decir, podemos coger una línea paralela, por ejemplo,al eje x, y adosar un cilindro a cada una de esas líneas. Pero también podrían estar adosadas al eje y. O, otra posibilidad, es que la orientación de los círculos fuera variando y se cerrasen sobre un círculo dibujado en el plano.

No tengo claro sí habría alguna consecuencia para la física «del plano» que dependiera de la orientación de los cilindros (aparentemente no, porque en relatividad general hablamos de geometría intrínseca, que no debería depender de ese aspecto, pero no estoy 100% seguro), pero, sin entrar en éso, ya tenemos un posible problema. Sí, cómo he razonado, parece plausible que el valor del móduli (el radio del círculo) surja de que un campo escalar, que vive en uno de los círculos, tome un valor de un potencial, que depende de la geometría interna de ése círculo, y ese potencial tiene varios mínimos posibles, entonces podría transmitir ese valor a los círculos de ese mismo cilindro, pero no está claro que dos cilindros paralelos se puedan comunicar entre si, y, por tanto, que dos cilindros paralelos deban tener el mismo valor del radio. En el caso de que los círculos se cierren formando un toro el asunto es aún peor pues cada zona del espacio podría tener su propio valor. Mas grave sería que cada círculo tuviera una orientación al azar, o que se agruparan por domínios, al estilo de los spines de los imanes.

Entonces una cuestión natural es ¿Hay varios valores posibles para los mínimos? Bueno, el valor del potencial lo fijan los flujos, y para ésos sí hay muchos valores posibles. Los flujos tienen valores cuantizados, pero hay una enorme cantidad de valores posibles. Hay un valor arquetípico  . Realmente ese es el problema del landscape, que hay muchos valores posibles, compatibles con el modelo standard (o con la constantes cosmológica). Se supone que, de hecho, hay saltos posibles de unos valores a otros de manera espontánea y que éso resolvería el problema de la constante cosmológica. Por supuesto se supone que los flujos son los mismos en cada punto del espacio-tiempo, dentro de un mismo espacio del multiverso, pero, igualmente, podría ser que hubiera una dependencia del flujo de un punto a otro (aunque ésto lo tengo menos claro).

. Realmente ese es el problema del landscape, que hay muchos valores posibles, compatibles con el modelo standard (o con la constantes cosmológica). Se supone que, de hecho, hay saltos posibles de unos valores a otros de manera espontánea y que éso resolvería el problema de la constante cosmológica. Por supuesto se supone que los flujos son los mismos en cada punto del espacio-tiempo, dentro de un mismo espacio del multiverso, pero, igualmente, podría ser que hubiera una dependencia del flujo de un punto a otro (aunque ésto lo tengo menos claro).

Otro aspecto muy curioso es el siguiente. Realmente un círculo requiere dos dimensiones. Si decimos que estamos compactificando a un círculo tenemos que asumir que hay dos dimensiones extra. Si, cómo hacemos en los dibujos, pintamos el círculo encima de una recta entonces tendremos que para dos rectas paralalas que estén a una distancia menor que el radio del círculo los cilindros de cada recta se solaparían unos con otros. Si consideramos el caso de «dos dimensiones extra», y una compacticiación en un toro, para cada circulo deberíamos tener dos dimensiones, dando lugar a 4. En realidad la cosa es un poco más compleja, porque podría tal vez haber alguna forma de acomodar ese toro de alguna manera que no requiera cuatro dimensiones. Por «acomodar» habría que especificar tecnicamente lo que queremos decir. Matemáticamente éso nos lleva a dos conceptos posibles que plasman la idea, la inmersión y el embedimiento (embbeding) cuyos detalles no voy a dar. El concepto mas fructífero y adecuado posiblemenente el embeding, y hay un teorema que nos dice que una variedad suave de dimensión n se puede, en el peor de los casos, embeber en un espacio  . A priori ésto no es un problema, pero, sí asumimos que estamos en un mundo que viene de la teoría de cuerdas, y éstas tienen originalmente 10 dimensiones, y se termina con 4 dimensiones extensas y 6 compactificadas, uno podría pensar que la variedad que está compactíficada debería también ser embebible en 6 dimensiones. Pero, claro, en todo este tiempo hemos dicho que las compactificaciones tienen como base el espacio de Minkowsky, pero, obviamente, éso no es el mundo real, que es un mundo curvo, por aquello de que cualquier masa curva el espacio. Incluso a gran escala, dónde podemos suavizar y considerar irrelevantes las fluctuaciones de curvatura de cuerpos astrofísicos, tenemos que, en su conjunto, el espacio es mas bien una esfera en expansión, y, si damos por bueno que hay una constante cosmológica, es, concretamente, un espacio de de Sitter. Y ése espacio no se puede embeber en un

. A priori ésto no es un problema, pero, sí asumimos que estamos en un mundo que viene de la teoría de cuerdas, y éstas tienen originalmente 10 dimensiones, y se termina con 4 dimensiones extensas y 6 compactificadas, uno podría pensar que la variedad que está compactíficada debería también ser embebible en 6 dimensiones. Pero, claro, en todo este tiempo hemos dicho que las compactificaciones tienen como base el espacio de Minkowsky, pero, obviamente, éso no es el mundo real, que es un mundo curvo, por aquello de que cualquier masa curva el espacio. Incluso a gran escala, dónde podemos suavizar y considerar irrelevantes las fluctuaciones de curvatura de cuerpos astrofísicos, tenemos que, en su conjunto, el espacio es mas bien una esfera en expansión, y, si damos por bueno que hay una constante cosmológica, es, concretamente, un espacio de de Sitter. Y ése espacio no se puede embeber en un  asi que ya vamos cortos de dimensiones. Por supuesto todo ésto que he dicho es irrelevante porque, fuera de las dimensiones de la teoría de cuerdas, no tiene sentido hablar de geometría y no deberíamos preocuparnos de en que embeber los espacios internos. Es obvio sí uno reflexiona sobre ello, pero no del todo inmediato, y, desde luego, no es algo que uno vaya a ver discutido en ningún libro serio, pero, tal cómo yo lo veo, ésa es una función de los blogs, poder discutir también cuestiones curiosas, y naturales, aunque no sean del todo serias ;-).

asi que ya vamos cortos de dimensiones. Por supuesto todo ésto que he dicho es irrelevante porque, fuera de las dimensiones de la teoría de cuerdas, no tiene sentido hablar de geometría y no deberíamos preocuparnos de en que embeber los espacios internos. Es obvio sí uno reflexiona sobre ello, pero no del todo inmediato, y, desde luego, no es algo que uno vaya a ver discutido en ningún libro serio, pero, tal cómo yo lo veo, ésa es una función de los blogs, poder discutir también cuestiones curiosas, y naturales, aunque no sean del todo serias ;-).

Por cierto, aunque a esto de los embeding y las imágenes mentales lo he presentado con un tono mas anecdotico que serio lo cierto es que no es un asunto trivial. En el libro que he mencionado, Particle Physics and Cosmology , los autores mencionan que el mecanismo de Kaluza tiene un pequeño problema debido a que la curvatura gaussiana de un cilindro es nula. Es fácil de entender porque es ésto. La curvatura gaussiana Cg en un punto es el producto de la curvatura máxima y la mínima de entre las curvas embebidas en la superficie Cg=Cmax*Cmin. En un cilindro la curvatura máxima es la del círculo que pasa por el punto, y la mínima la de la recta que pasa por ese punto. Cómo la curvatura de una recta es 0, Cg=Ccírculo*0=0. Por supeusto ésto da carta de naturaleza a que hay que «tomarse en serio» la imagen mental del cilindro, pero, en ése caso tenemos que tomarnos también en serio las consideraciones sobre la orientación de ésos cilindros, o porqué cilindros y no toros, etc, etc.

En fin, es una entrada larga, y dura en muchos aspectos, espero que se haya entendido algo. Tengo previsto escribir pronto sobre las teorías unificadas de Einstein, pero cómo estas incluyen Kaluza-Klein, me pareció oportuno comentar estas reflexiones exóticas sobre ese tema que se me han ido ocurriendo este año. De hecho, la parte de la física mas allá del modelo standard que pueda ser no constante en el espacio y tiempo, posiblemente sea mucho mas interesante, dentro de la ortodoxia cuerdista actual, que las teorías de unificación de Einstein, que es algo que he estudiado sólo por influencia de la serie Genius 🙂